[논문리뷰] Wild-GS: NeRFwithRealWorld + 3D GS + Depth Regularization - Wild-GS: Real-Time Novel View Synthesis from Unconstrained Photo Collections (Arxiv 2024)

💡 본 문서는 'Wild-GS: Real-Time Novel View Synthesis from Unconstrained Photo Collections (Arxiv 2024)' 논문을 정리해놓은 글이다.

해당 논문은 관광객이 찍은 데이터셋을 활용하여 3D Reconstruction을 진행하는 Task(unstructured tourist environments)를 해결하기 위한 논문이다. 이는 NeRF 기반이 아닌 Gaussian Splatting 을 활용하였으며, Hierarchical Appearance Modeling과 Depth Regularization을 진행한 것이 특징이니 참고하기 바란다.

- Paper: https://arxiv.org/abs/2406.10373

Abstract

Wild-GS는 3D Gaussian Splatting(3DGS) 기반 기법을 제안하여, 불규칙한 관광지 사진 데이터(unconstrained photo collections)에서도 효과적인 장면 재구성과 노벨 뷰 합성을 가능하게 한다. 기존의 NeRF 기반 기법은 동적 외관과 일시적인 객체를 처리하기 위해 추가 모듈을 도입했지만, 훈련 시간이 길고 렌더링 속도가 느린 한계가 있었다.

Wild-GS는 각 3D 가우시안의 appearance을 material attributes, global illumination and camera properties per image, and point-level local variance of reflectance을 통해 결정하여, 고유한 참조 이미지의 고주파 세부 정보를 3D 공간으로 효과적으로 전이시킨다. 또한, 2D visiblity map과 depth regularization를 통해 Transient한 효과를 줄이고 기하학적 구조를 제약한다. 실험 결과, Wild-GS는 기존 방법보다 빠르고 정확한 훈련 및 추론 효율성을 달성하며, 최첨단 렌더링 성능을 보여준다.

이 논문이 가지는 contribution 중 가장 메인이 되는 부분을 정리해보면 다음과 같다.

- illumination과 tone 같은 Scene의 특징을 반영한 Global Appearance Embedding과 Position-aware한 특징을 반영한 Local Appearance Embedding 을 잘 활용하여 SH에 효과적으로 Appearance를 반영하였다.

- Depth Anything 모델을 활용하여 Depth Regularization을 진행하였다.

Methods

- (a) Global appearance embedding Emb^g capturing the illumination level or tone mapping of the entire scene;

- (b) Local appearance embedding Emb_i^l describing the positional-aware local reflectance for i-th 3D Gaussian;

- (c) Intrinsic feature f in i storing the inherent attributes of the material in the dominant area for each Gaussian.

Before rasterization, a shared fusion network MF θ is leveraged to decode the view-dependent color sh from these three appearance components:

1. Hierarchical Appearance Modeling

1-1) Global Appearance Embedding (Emb^g)

the low-frequency appearance changes among the entire scene.

- F_I_R: the feature maps obtained from the UNet encoder(ResNet-18 pre-trained by ImageNet) in the 2D Parsing module

- AvgPooling: global average pooling

- M^G_θ: a trainable MLP

1-2) Local Appearance Embedding (Emb_i^l)

2D -> 3D: back-project the reference image I_R into the space using the rendered depth D^_I_R and camera parameters ω_I_R

- M_I_R: visibility mask

- Th: threshold distinguishing the transient objects

- {CIR , PIR} refers to the generated point cloud with positions PIR and colors CIR

3D -> 2D(triplane): the 3D points are normalized for re-projection onto the three orthogonal planes defined by the triplane

where P~_I_R represents the normalized point positions.

- {c′_xy, c′_yz, c′_zx}: triplane color of each axis corresponding reverses

- UNet U^3D_θ: to extract the triplane feature maps F^T_I_R

The positional-awareness local appearance embedding utilized to interpolate the three plane features {fixy, fiyz, fizx} for each 3D Gaussian.

1-3) Intrinsic Feature f in i

- a learnable intrinsic appearance feature

- which remain consistent despite environmental changes.

- Inspired by EAGLES (Girish et al., 2023), which compresses the attributes of the 3D Gaussian into a low-dimensional latent vector.

2. Depth Regularization

Depth information는 the sparse view reconstruction에 종종 사용한다(Deng et al., 2022; Li et al., 2024; Zhu et al., 2023). Wild-GS에서도 렌더링된 깊이를 활용하여 Reference View(2D)를 3D space 상에 back project 하는데 사용한다.

이때, 각 reference view에서 깊이 정보를 보정하기 위해 Depth Anything (Yang et al., 2024) 사용하여 추정한 깊이 정보를 활용하여 Regularization을 진행한다. 이는 Rendered Depth와 Estimated Depth 사이에 Pearson correlation loss(proposed by FSGS (Zhu et al., 2023))를 적용하여 구현하였는데, 이 Pearson correlation loss는 transient object를 masking하는 방식으로 수정하여 사용했다.

3. Handling Transient Objects

Experimental

Experimental을 확인해보면, NeRF in the Wild Task 내에 GS를 활용한 방법론들이 많으나, 해당 논문은 NeRF based 논문과만 성능을 비교한 것을 확인할 수 있다.

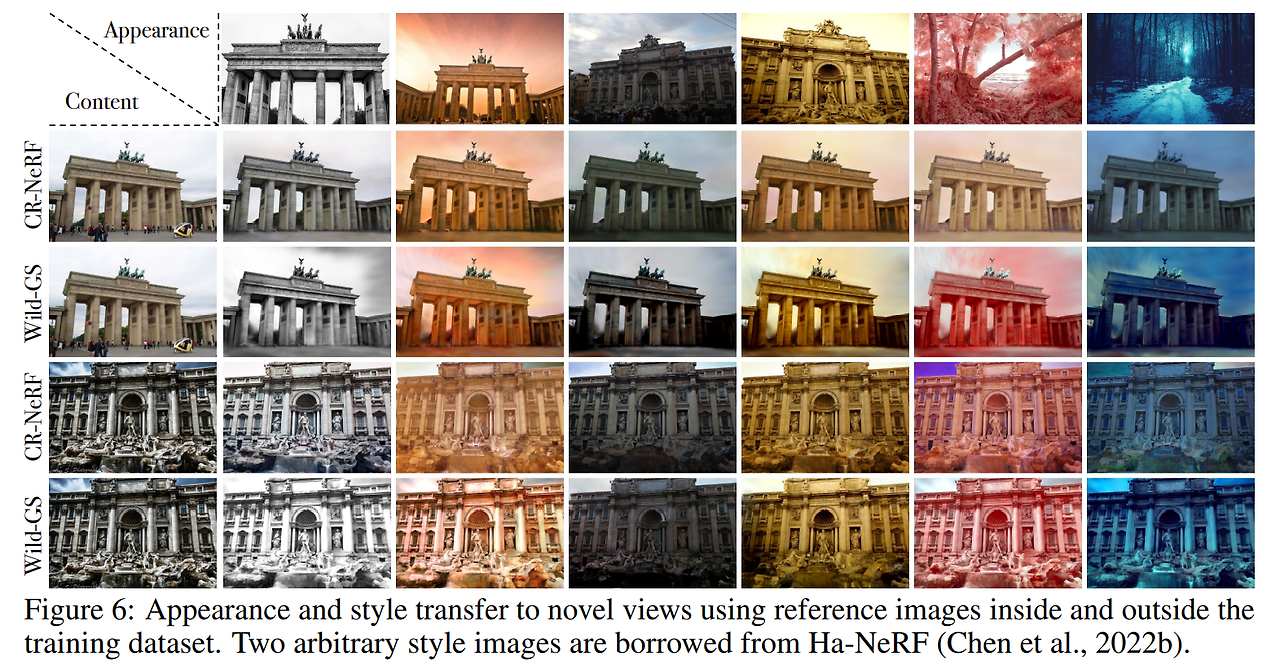

정성적인 평가 결과 또한, NeRF based Method와만 비교하였는데 다른 것에 비해 Appearance를 잘 반영하는 모습은 확인할 수 있다.